探索两种深度学习路径:Keras和TensorFlow在风格迁移中的应用

在深度学习领域,Keras和TensorFlow是两个非常流行的库,它们都提供了强大的工具来构建和训练神经网络。风格迁移是一种计算机视觉技术,它允许我们结合两幅图像——一幅作为内容的主体,另一幅作为风格的来源——生成一种新的图像,它在视觉上类似于内容图像,但风格上则模仿了风格图像。在本文中,我们将探索如何使用Keras和TensorFlow实现风格迁移。

风格迁移简介

风格迁移的概念最早由Gatys et al. (2015)提出。该技术通过优化一个目标函数来实现,该函数由三部分组成:内容损失(content loss)、风格损失(style loss)和总变分损失(total variation loss)。

- 内容损失确保生成的图像在内容上与原始图像相似。

- 风格损失确保生成的图像在风格上与参考图像相似。

- 总变分损失添加了一个正则项,以保持生成图像的局部空间连续性,从而提高其视觉质量。

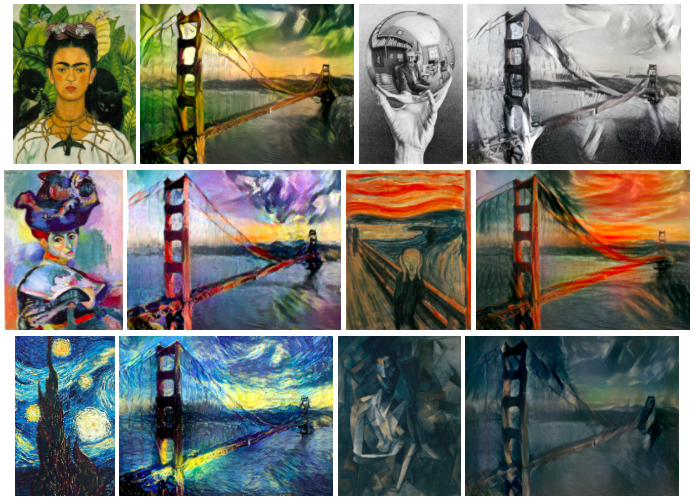

图像风格迁移示例

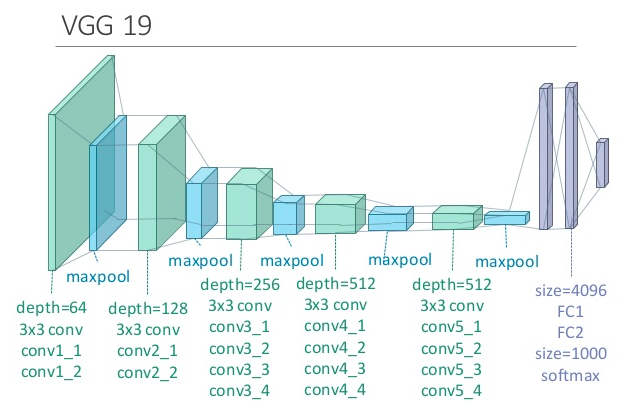

VGG19模型结构

VGG-19模型的结构,它是一个经典的深度学习卷积神经网络(CNN),由牛津大学的视觉几何组(Visual Geometry Group)开发,因此得名VGG。VGG-19模型在2014年的ImageNet挑战赛中取得了优异的成绩,并且因其简单和高效而广泛用于图像识别任务中。

VGG-19模型的特点包括:

-

多个卷积层:模型由多个卷积层组成,每个卷积层后面通常跟有一个最大池化层(maxpool),用于降低特征图的空间维度。

-

卷积层的深度:卷积层的过滤器数量(或称为深度)随着网络的深入而增加,从64增至128,再到256,最后是512。

-

全连接层(FC):在所有卷积和池化层之后,网络包含有两个全连接层(FC1和FC2),它们将卷积层的高级特征映射到最终的分类结果。

softmax层:最后一个softmax层用于生成类别的概率分布。

3x3卷积核:VGG-19模型中所有的卷积层都使用了3x3的卷积核,这有助于减少计算量和参数数量。

在神经风格迁移算法中,VGG-19模型通常被用来提取内容图片和风格图片的特征,以计算内容损失和风格损失。这些损失函数定义了风格迁移的目标,即生成的图像在视觉上看起来像内容图片,但风格上模仿风格图片。

完整代码

目录

├─content.jpg

├─imagenet-vgg-verydeep-19.mat

├─main_keras.py

├─main_tf.py

├─style1.jpg

├─style2.jpg

├─style3.jpg

├─style4.jpg

├─style5.jpg

├─neural_style_transfer_tensorflow

| ├─output_0.jpg

| ├─output_100.jpg

| ├─output_1000.jpg

| ├─output